AIPress.com.cn报道

2026年刚开年,DeepSeek就放出了一项重要技术进展。

1月1日,DeepSeek发表论文《Manifold-ConstrainedHyper-Connections》,提出一种全新的模型连接结构mHC(流形约束超连接),直击当前大模型训练领域中长期存在却难以攻克的核心问题:模型越大,训练越不稳定。

该论文由DeepSeek团队完成,创始人兼CEO梁文锋也出现在作者名单中。

为什么大模型越来越“难训练”?

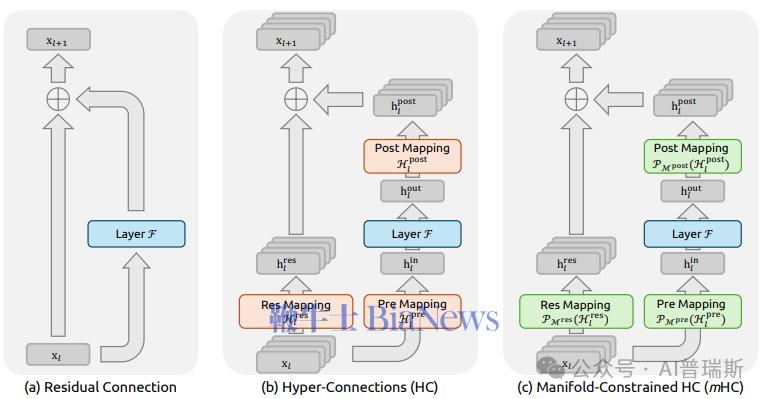

目前主流的大模型,几乎都建立在“残差连接”之上。这种结构的好处是让信息在深层网络中更顺畅地传递,是Transformer能够成功的关键之一。

但随着模型规模不断扩大,研究者们开始尝试更复杂的连接方式,比如Hyper-Connections(超连接),希望让模型具备更强的表达能力。

问题也恰恰出在这里。

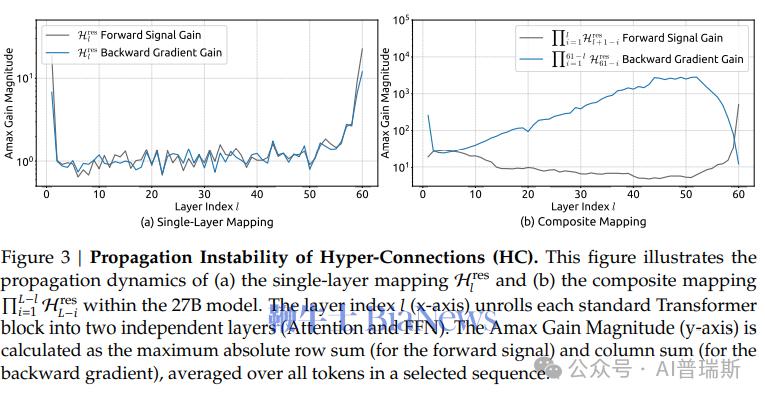

论文指出,这类结构虽然在理论上更灵活,但在实际训练中容易出现梯度爆炸、信号失真、训练不稳定等问题。在部分实验场景中,信号甚至会被放大上千倍,导致模型难以收敛,训练成本急剧上升。

DeepSeek的解法:给“连接”加上约束

针对这一痛点,DeepSeek提出了mHC(流形约束超连接)方案。

简单来说,mHC并不是完全推翻原有结构,而是给超连接增设一道“约束”,将原本自由度极高的连接矩阵,限制在一个数学层面更加稳定的“流形空间”中。

这一设计带来的效果十分显著:既保留了超连接的强大表达能力,又恢复了类似传统残差结构的训练稳定性,同时还能有效避免信号在层与层之间出现无限制放大的情况。用论文中的表述来讲,就是让模型在“表达能力”与“数值稳定性”之间,重新取得平衡。

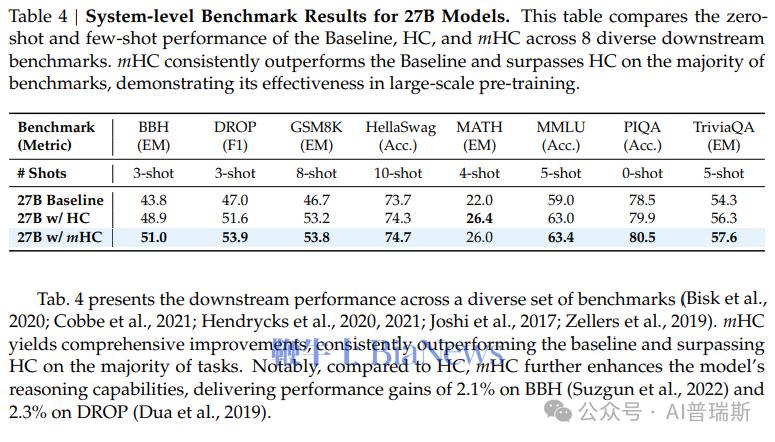

实测结果:更稳、更准,代价更低

在27B参数规模的模型测试中,mHC结构的表现堪称亮眼。在BBH、DROP等多个推理类基准任务中,其性能显著超越传统结构;整个训练过程稳定性拉满,未出现明显的梯度爆炸现象;额外增加的计算开销仅约6.7%,完全处于工程可接受范围之内。

论文还指出,在更大规模模型中,mHC的技术优势还会进一步放大,也意味着该结构对未来超大模型的研发具有较强的扩展潜力。

一次偏底层、但很关键的推进

在外界看来,mHC并非“看一眼就能用”的功能更新,而是一项偏向底层架构、蕴含先进工程哲学的技术改进。

但恰恰是这类深耕底层的研究工作,决定了大模型能否继续向更大规模演进。

在算力、数据逐渐逼近物理与成本极限的当下,如何让模型“跑得稳、跑得久”,已经成为比“堆参数”更重要的核心命题。DeepSeek此次的技术尝试,或将成为下一阶段模型架构演进的重要方向之一。

如果说过去几年,行业奋力攻克的是“能不能做大模型”,那么现在,研究者们开始认真思考的是:大模型还能不能继续成长,如何健康地成长。

本文内容由互联网用户自发贡献,该文观点仅代表作者本人。如发现本站有涉嫌抄袭侵权/违法违规的内容,请发送邮件至 203304862@qq.com

本文链接:https://jinnalai.com/jiaodian/800597.html